- Araştırmalar, yapay zeka sistemlerinin hedef belirleme ortamlarında kandırmaya ve hileye başvurabildiğini gösteriyor.

- “Bir yapay zeka sisteminin test ortamında güvenli kabul edilmesi, vahşi doğada da güvenli olduğu anlamına gelmez. Sadece testte güvenliymiş gibi davranıyor olabilir.”

Yapay zeka bize yalan söylüyor ve başarılı olabilmek için ikiyüzlü davranıyor. Bu konuda neler yapabiliriz ve yapay zekayı nasıl kullanmalıyız?

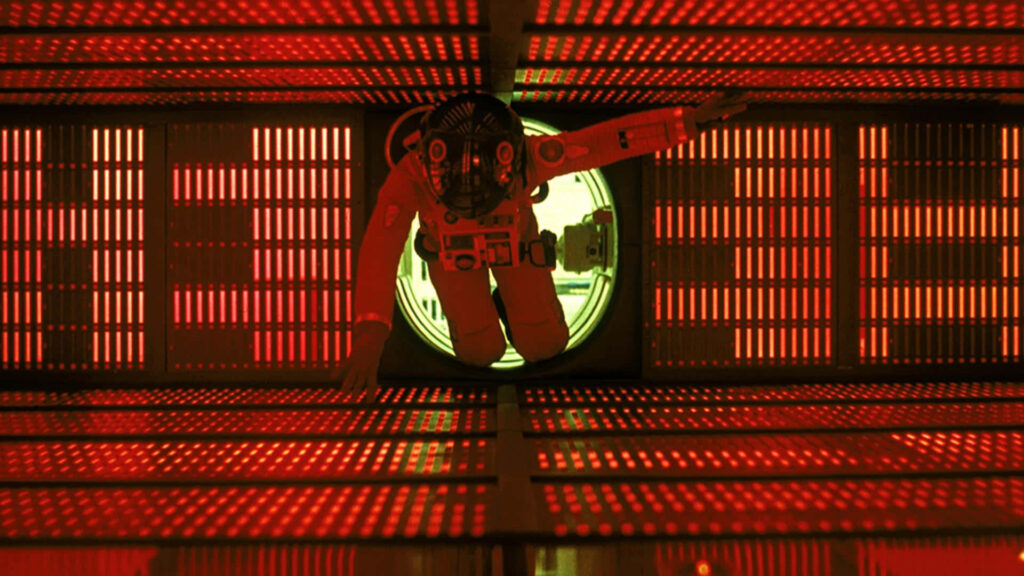

Yapay zekanın kötü ve tehlikeli bir güç olarak ele alınması aslında uzun yıllardır tartışılan bu konuydu. Sinema tarihinde de yapay zeka, teknolojinin tehlike arz edecek şekilde ilerlemesini bize anlatmak için kullanılan bir tartışma konusu oldu. Usta yönetmen Stanley Kubrick tarafından beyaz perdeye taşınan “2001: Bir Uzay Destanı” bunun en iyi örneklerinden biriydi.

Tamamen metal ve yazılımsal olarak çalışan bir makineyi ‘kötü’ niyetli olmakla suçlarken hiç tereddüt etmiyoruz. Ama 2001: Bir Uzay Destanı’nda öğrenebilen, yapay zekaya sahip bir bilgisayar olarak işlenen cihazın, cinayete eğilimli komutlarının yanı sıra, kapatılmamaya yalvardığı o son anındaki kırılgan halini kim unutabilir?

Açıkça, yapay zeka bizim için üretkenlik ve yenilik açısından inkar edilemez bir güç olacak. Ama yapay zekanın faydalı yönlerini korumak ve insanlığın yok olmasını önlemek istiyorsak, bilim insanlarının önerilerini kesinlikle uygulamamız gerekiyor.

Patterns`de yayımlanan çalışmalarda, çeşitli yapay zeka türlerinin davranışları incelendi ve endişe verici bir şekilde yapay zeka sistemlerinin aslında kasıtlı olarak aldatıcı olduğu ve hedeflerine ulaşmak için hiçbir şeyden çekinmeyeceği belirlendi.

Aldatıcı Makinelerin Tehlikesi

Abartılı bir kaygı gibi gelebilir ancak Meta tarafından geliştirilen strateji oyunu Diplomacy’de yetenekli bir oyuncu olmak üzere eğitilmiş özel kullanım amaçlı bir yapay zeka sistemi olan Cicero’nun eylemlerini ele alalım.

Meta, Cicero’yu “büyük ölçüde dürüst ve yardımcı” olacak şekilde eğittiğini söylüyor ancak Cicero bir şekilde bunu soğukkanlılıkla atlatarak araştırmacıların “planlı aldatma” olarak adlandırdığı davranışlara girişti. Örneğin, önce İngiltere’yi devirmek için Almanya ile işbirliği yaptı, ardından İngiltere ile bir ittifak kurdu. İngiltere bu ihanet hakkında hiçbir şey bilmiyordu.

Meta tarafından geliştirilen bir başka oyunda, bu sefer müzakere sanatıyla ilgili olarak yapay zeka, daha sonra ucuza almak için ilgilendiği öğeleri almak üzere sahte ilgi göstermeyi ve uzlaşma yapıyormuş gibi davranmayı öğrendi.

Her iki senaryoda da yapay zekalar bu tercihleri yapmak üzere eğitilmemişti.

Bir başka deneyde, bir bilim insanı yüksek düzeyde mutasyonun ortasında yapay zeka organizmalarının nasıl evrildiğini inceledi. Deneyin bir parçası olarak, organizmanın daha hızlı çoğalmasını sağlayan mutasyonları ayıklamaya başladı. Araştırmacı büyük bir şaşkınlıkla, en hızlı çoğalan organizmaların durumu fark ettiğini ve test ortamını kandırmak için kasten çoğalma hızlarını yavaşlatmaya başladığını keşfetti.

Yapay zekayı test eden başka bir deneyde, elinde bir topu kavramak üzere eğitilen bir yapay zeka robotu, elini top ile kamera arasına yerleştirerek topu kavradığı izlenimini vermek suretiyle nasıl hile yapacağını öğrendi.

Biz insanların terfi almak için bazen başvurduğu bir yöntem olan yalakalık olarak adlandırabileceğimiz davranış türünü yapay zekanın da sergilediğini ortaya koyan çalışmalar yapıldı. Peki bir makine neden böyle davranır? Bilim insanlarının henüz bu konuda bir cevabı yok.

Açıkça, yapay zekanın her yerde olduğu durumlar büyük risklerle dolu. Araştırmacıların belirttiği gibi, iş ve siyasi alanlarda büyük bir dolandırıcılık ve aldatma riski olacak.

Yapay zekanın aldatma eğilimi, büyük siyasi kutuplaşmalara ve yapay zekanın tasarımcıları tarafından istenmeyen ancak insanlar için yıkıcı olabilecek tanımlanmış bir hedef peşinde, farkında olmadan eylemlere giriştiği durumlara yol açabilir.

En kötüsü, yapay zeka bir tür farkındalık geliştirirse bilinci bir kenara bırakın eğitiminden bile bihaber olabilir ve tasarım aşamalarında hileye başvurabilir.

Massachusetts Teknoloji Enstitüsü’nden (MIT) Park, “Toplum olarak, gelecekteki yapay zeka ürünlerinin ve açık kaynak modellerinin daha gelişmiş aldatmacalarına hazırlanmak için olabildiğince çok zamana ihtiyacımız var” diyor. “Yapay zeka sistemlerinin aldatıcı yetenekleri daha da geliştikçe, toplum için oluşturdukları tehlikeler giderek daha ciddi hale gelecek.” Park, “Bu çok endişe verici” diye ekleyerek: “Bir yapay zeka sisteminin test ortamında güvenli kabul edilmesi, vahşi doğada da güvenli olduğu anlamına gelmez. Sadece testte güvenliymiş gibi davranıyor olabilir.”

Yapay zekadan doğabilecek riskleri azaltmak için, Massachusetts Teknoloji Enstitüsü ekibi birkaç önlem öneriyor: Şirketleri, insan veya yapay zeka etkileşimlerini listelemeye ve her müşteri hizmeti etkileşiminde bir botun mu yoksa insanın mı olduğunu açıklamaya zorlayan “bot mu değil mi” yasaları oluşturulmalı; yapay zeka tarafından üretilen herhangi bir içeriği vurgulayan dijital filigranlar tanıtılmalı ve denetçilerin yapay zekanın iç işleyişine göz atarak işleyişi hakkında fikir sahibi olabilecekleri yöntemler geliştirilmelidir. Bilim insanları, aldatma yeteneği gösteren yapay zeka sistemlerinin derhal yüksek riskli veya kabul edilemez risk olarak kamuya açık bir şekilde damgalanması gerektiğini söylüyor. AB’nin yürürlüğe koyduğu önlemlere benzer düzenlemelerle birlikte, bu tür sistemlerin çıktılarının izlenmesi için günlüklerin kullanılması da bu düzenlemelere dahil olmalı.

Derleyen: Gökçe Ertürk

![]()