Anthropic tarafından geliştirilen iyi ve kötüyü ayırt eden Claude; özgürlük, eşitlik, kardeşlik duygusu ve bireysel haklara saygı çerçevesinde yanıtlar vermeye odaklanıyor.

OpenAI’n eski araştırmacıları tarafından yönetilen bir şirket olan Anthropic, yapay zekânın genellikle hayali ve rahatsız edici içerik üretmesi nedeniyle, minimum insan müdahalesi ile neyin iyi neyin kötü olduğunu bilebilecek bir AI geliştiriyor.

Evrensel İnsan Hakları Beyannamesi’nden ilham alan Anthropic’in sohbet robotu Claude benzersiz bir “anayasa” ile tasarlandı. Bununla birlikte, bir “anayasa” kavramı, gerçek olmaktan çok mecazî bir anlam taşımakta.

Eski bir OpenAI danışmanı ve Anthropic’in kurucularından biri olan Jared Kaplan, Claude’un yapısının, herhangi bir eğitmenin, yapay zekâsını modellemek için kullandığı belirli bir eğitim parametreleri seti olarak yorumlanabileceğini söyledi.

Şirket resmî web sitesinde, “Anayasal yapay zekâ ve zararsızlık eğitimi sayesinde, şirketinizi ve şirketinizin ihtiyaçlarını temsil etmesi için Claude’a güvenebilirsiniz. Claude, hoş olmayan ve kötü niyetli sohbet ortaklarıyla bile zarafetle başa çıkmak için eğitildi.” yazıyor.

Claude, 100 binden fazla bilgi simgesini işleyebiliyor. Bu durum da Claude’un ChatGPT, Bard veya şu anda mevcut olan yapay zekâ sohbet robotlarına göre daha fazla bilgi işleyebileceğini gösteriyor.

Yapay zekâ alanında “simge” genellikle, modelin ayrı bir birim olarak işlediği kelime veya karakter gibi veri yığınlarını ifade eder. Claude’un simge kapasitesi, onun kapsamlı konuşmaları ve karmaşık görevleri yönetmesine izin verir.

AI ve İyiye Karşı Kötünün Göreliliği

Yapay zekâda etik konusundaki endişe; acil durumda, ancak yine de nüanslı ve öznel bir alanı ifade etmekte. Yapay zekâ eğitmenlerin yorumuna göre etik kurallar, toplumsal normlar ile geniş açıdan uyumlu değilse yapay zekâ modelini sınırlayabilir. Bir eğitmenin kişisel “iyi” veya “kötü” algısına aşırı vurgu yapmak, yapay zekânın güçlü, tarafsız tepkiler üretme yeteneğini azaltabilir.

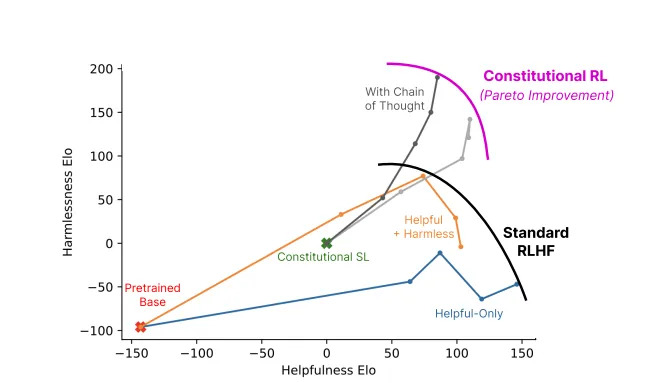

Claude’un etik çerçeveyi yapay zekâda uygulama çalışması deneysel olması ile birlikte Anthropic tarafından belirtildiği gibi sohbet robotlarının etik olarak kötüye kullanılmasıyla mücadele edilmesi AI endüstrisinde dikkate değer bir hamle.

Claude’un etik eğitimi; özgürlüğü, eşitliği, kardeşlik duygusunu ve bireysel haklara saygıyı desteklemeye odaklanarak anayasa metinleri ile uyumlu yanıtları seçmeyi teşvik ediyor. Ancak bir yapay zekâ tutarlı bir şekilde etik yanıtları seçebilir mi?

Kaplan, teknolojinin pek çok kişinin tahmin edebileceğinden daha fazla ileride olduğuna inanıyor. Geçen hafta Stanford MLSys seminerinde “Bu sadece basit bir şekilde çalışıyor. Bu süreçten geçtikçe zararsızlık gelişir.” dedi.

Anthropic’ten Claude bize yapay zekâ gelişiminin sadece teknolojik yarış olmadığını ayrıca felsefî bir yolculuk olduğunu hatırlatıyor.

Claude, sadece daha “akıllı” bir yapay zekâ oluşturmakla ilgili değil; ayrıca en uçtaki araştırmacılar için, doğruyu yanlıştan ayıran ince çizgiyi kavrayan bir yapay zekâ oluşturmakla ilgili bir deneyim olduğunu ortaya koyuyor.

Derleyen: Serap Atabey